-

开放科学(资源服务)标志码(OSID):

-

烟蚜(Myzus persicae)又名桃蚜,隶属半翅目(Hemiptera)蚜科(Aphididae),是烟草重要害虫之一[1]. 烟蚜的体长大约2 mm,春季时体色为绿色,夏季为黄绿色或黄白色,秋季则变为红褐色. 烟蚜各虫态的发育起点温度为9.8 ℃,繁殖方式主要是孤雌胎生,分为有翅和无翅两种类型. 无翅烟蚜的腹管长筒形,尾片圆锥形,黑色,有6~7根曲毛;而有翅烟蚜的腹部有黑褐色斑纹,翅透明,翅痣灰黄或青黄色[2]. 烟蚜通过其尖锐的口针直接刺入烟株的韧皮部,吸取其中的汁液,从而对烟株造成损害[3]. 烟蚜还会携带并传播多种病毒,如烟草黄瓜花叶病毒,马铃薯Y病毒等[4-5]. 烟蚜在全国各地的烟草种植区域普遍存在,对我国烟草产业造成了严重的经济损失. 烟蚜在重庆烟区造成的经济损失就高达2 000多万元[6]. 由于烟蚜的为害情况判断不准确,烟农长期盲目施药,导致烟蚜的抗药性增强、资源浪费以及农药残留等问题日益凸显.

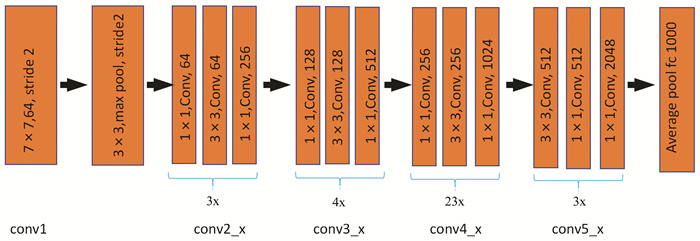

图像识别技术是一种利用计算机视觉和图像处理技术来自动检测和分析目标的一种研究方法. ResNet,全称为残差网络(Residual Networks)[7],是一种深度学习架构,主要贡献是解决了图像识别中随着网络深度增加时训练困难的问题,使得模型能够设计和训练更深的网络结构,从而在多个视觉识别任务中取得了显著的性能提升[8]. ResNet101是Resnet家族中经典的深度残差网络(Residual Networks),包含101层,在每个残差块中,输入会直接跳过一些层与块的输出相加,这样的设计允许网络学习输入和输出之间的残差,而不是直接学习映射关系,简化了学习过程并提高了网络的学习能力,使得可以构建更深的网络并提高图像识别的性能[9]. 本研究采用ResNet101模型,对田间烟草蚜虫为害情况图片进行训练. 通过调整参数获得最佳图像识别效果,以期为烟草虫害自动化防治系统的开发提供模型支撑.

全文HTML

-

根据烟蚜发生数量图像识别系统开发需求,本研究的图像样本采集选择在烟田中进行. 拍摄者采用手机,在距离烟叶20 cm处进行拍摄,拍摄过程中采用原相机,不开闪光灯,不进行焦距缩放,确保图像的自然背景与实际生长条件最大程度上相符. 为了获取全面的虫害信息,需要从不同的角度和方位进行图像采集,本研究采用叶面正视、正面45 ℃、背面正视3个角度进行拍摄.

-

对采集数据进行预处理,去除质量不高及模糊不清的图像,进行统一标注. 按照烟蚜对烟草为害情况进行3级分类,分类参考《烟草有害生物的调查与测报》[1]. 该分类的目的是将烟蚜发生的数量对烟草为害情况进行数字化表达,解决传统经验判断带来盲目施药、指导防控偏差等问题. 对采集到的图像进行尺寸统一化调整,并使用图像注释工具对采集到的图像进行精确的标记和注释.

-

为了增强图像数据并提升模型的泛化性能,采用了多种图像预处理技术,包括图像旋转、缩放、裁剪以及颜色调整等. 在完成图像增强后,将数据集划分为3个部分:训练集、验证集和测试集,有助于模型在训练过程中进行有效的自我验证,并在测试阶段评估其性能. 在模型训练阶段,引入Rectified Linear Unit(ReLU)激活函数,以解决训练中可能遇到的梯度消失问题,同时加快模型的训练速度,提高训练效率. 采用Adam优化器来更新模型参数. Adam优化器可以自适应学习率调整,能够有效地优化模型的训练过程,进一步优化训练效果,将学习率设置在0.01至0.001的范围内,以确保模型能够在训练过程中稳定地收敛. 采用StepLR调度器来动态调整优化器的学习率,这种方法能够根据训练进度逐步调整学习率,从而在不同阶段实现更加精细模型优化,优化训练效果. 为了增强图像的识别能力,对图像进行了灰度化处理,在这一过程中采用加权平均法,突出图像中的关键信息,提高模型对图像特征的识别精度. 采用边缘分割法来进行图像分割,用以准确地识别图像中边缘信息,为后续的特征提取和模型训练提供高质量的输入数据. 为了进一步优化学习率的调整策略,设定在每个epoch结束后将学习率乘一个因子gamma,该因子的取值范围在0.1和0.5之间. 设定在每10个epoch结束后对模型的学习速率进行一次调整,确保模型训练的稳定性和效率. 在训练过程中,总共进行了50次迭代(epoch). 在其他参数的设置上遵循常规设定方法.

-

模型评价从训练集损失值、测试集损失值、训练集准确率、测试集准确率等方面进行. 选取最优化模型进行系统可视窗开发. 随机选取100张图片进行系统识别,按照正确识别张数/100计算识别实际准确率.

1.1. 数据采集

1.2. 数据清洗

1.3. 模型参数设置

1.4. 模型结果评价

-

研究共获得拍摄图像2 036张,通过筛选,保留有效图像1 537张,共分为3级. 1级:轻度为害图像共879张,2级:中度为害图像共416张,3级:重度为害图像共242张. 经过图像增强后数据扩增3 000张(图 2).

-

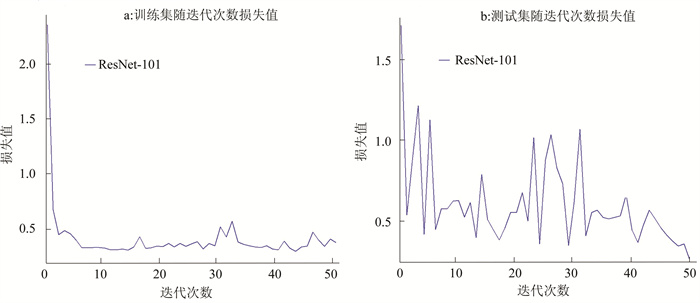

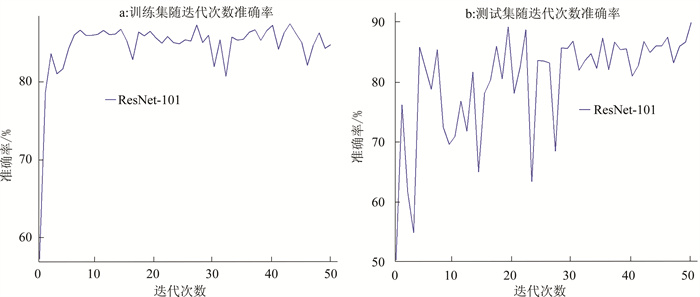

本研究中,图像识别模型训练使用Win11 X64操作系统,开发选择深度学习开源框架PyTorch. 计算机运行内存为32 GB,搭载13th Gen Intel(R) Core(TM) i7-13900H 2.60 GHz,支持GPU加速和动态神经网络,GPU采用英伟达RTX 3060Ti对深度学习模型进行加速. 在本次研究中,将模型训练周期设置为50 Epoch. 训练集与测试集拟合结果如图 3所示(a:训练集损失值;b:测试集损失值). 模型训练集损失值在5次迭代后逐渐趋于稳定,在整体周期中训练集损失平均值为0.403 6. 测试集相较于训练集呈现波动较大,但存在逐渐降低趋势,在进行40次迭代后趋于稳定,整体周期中训练集损失平均值为0.605 1.

模型整体迭代中,训练集准确率与测试集准确率如图 4所示(a:训练集准确率;b:测试集准确率). 训练集准确率在模型进行7次迭代后逐渐趋于稳定,在整体周期中训练集准确率平均值为85.49%,最高值为87.33%. 测试集准确率拟合曲线波动较大,前期出现多次准确率较低的情况,迭代30次后准确率逐渐趋于稳定,在整体周期中测试集准确率平均值为80.13%,最高值为89.92%.

-

为验证烟蚜发生数量图像识别系统的可靠性,采用数据进行检验. 采集田间有效图像100张,其中,1级图片40张,2级图片30张,3级图片30张. 导入测试系统,通过识别窗口输出结果与真实结果进行对比,测试模型准确率,系统测试结果如图 5所示. 在1级40张图片中正确识别35张,准确率87.5%;在2级30张图片中正确识别25张,准确率83.3%;在3级30张图片中正确识别23张,准确率76.6%;整体识别准确率83.00%.

2.1. 图像处理结果

2.2. Resnet 101模型运行结果

2.3. 烟蚜危害图像识别系统检验

-

图像识别技术已经广泛应用在农作物生产当中. 刘欣谊等使用无人机航拍获取小麦生育前期的RGB图像,通过图像处理获取小麦田间颜色和纹理特征指数,并在小麦收获后测定实际产量[10]. 曲福恒等在多尺度Retinex算法中加入颜色恢复函数调节3个通道颜色的占比以恢复其颜色特征,提高模型准确率使其能快速进行作物杂草识别[11]. 孙翔等采用连通域分析法计算标尺色块的像素高度,通过标尺像素高度和实际高度的比例关系计算株高,使图像识别可进行作物株高测量[12]. 在使用深度学习框架对作物虫害图像识别研究方面也取得了大量进展. 汪健等对ResNet34网络进行改进,提高网络的识别能,以实现基于给定的图像自动地识别分类出主要害虫[13]. 肖衡采用深度学习算法解决传统测报系统中存在的误报率高问题,初步实现对水稻飞虱虫害的诊断[14]. 马佳佳等在基于优化SVM框架中,采用HOG特征描述符提取图像特征信息,通过粒子群优化算法提高对草地贪夜蛾成虫图像识别的准确率[15].

本研究基于pytorch程序,采用Resnet 101模型,通过对生产中采集到的烟蚜数量图片进行识别处理,设计烟蚜数量图像识别系统. 该系统主要包括图像输入、数据增强、特征提取、分级判断4个过程. 系统对生产中实际拍摄图片测试结果表明模型可以满足应用要求. 研究发现影响系统准确率主要因素是:数据中3级样本较少,导致可训练数据样本图不够,模型训练过程中出现过拟合现象,致使准确率较低. 后期将通过解决该问题对模型进行再次训练,提高模型整体准确率. 本研究通过图像识别技术提供烟蚜田间发生情况判断结果,依据模型输出结果可以解决传统经验判断带来的误差. 同时识别系统可以为烟蚜在田间防治提供参考[16-17].

下载:

下载: