-

随着计算摄影学的发展,光场相机逐渐引起人们的关注,不同于传统的小孔成像,光场相机可以捕获光线的位置和方向信息,通过一次曝光即可获得场景的多视角图像,这使得光场图像在超分辨率重构、场景三维重建、立体视觉等领域得到了广泛应用.然而光场相机的空间分辨率和角度分辨率相互制约,使其成像分辨率不高,这也限制了它的商用.光场图像重聚焦技术是光场相机的一大亮点,将一组光场数据经过重聚焦处理可以得到聚焦在不同深度的图像序列,即生成光场图像的焦点堆栈.如果能够将聚焦在不同位置的焦点堆栈图像融合成一幅光场全聚焦图像,就可以在一定程度上解决光场图像分辨率不高的问题.多聚焦图像融合是一种有效的获取全聚焦图像的方法,融合结果包含所有源图像中的聚焦信息,更适合于人类视觉感知.在过去的几十年中,研究者提出了许多图像融合方法,这些方法大致可以分为两类:空间域方法和变换域方法[1-2].空间域方法多采用基于块的融合策略,该方法将源图像分割成大小相等的块,并根据设计的活度测量值对每对块进行融合.显然,融合结果的质量取决于块的大小,为了避免块大小的选择,文献[3-4]提出了自适应块方法,并引入了基于四叉树的方法,根据图像内容自适应地将源图像分成不同大小的块.变换域方法通常将源图像转换到特征空间中,在特征空间中找到一些显著的特征.目前常见的变换域方法包括拉普拉斯金字塔(LP)、梯度金字塔(GP)、离散小波变换(DWT)、弯曲变换(CVT)和非下采样轮廓波变换(NSCT)[5-8],这些多尺度变换域方法都是假设所选变换域的分解系数可以代表源图像的活性水平.可以看出,采用图像融合的方法处理多聚焦图像得到了广泛的关注,并取得了较多的研究成果.

光场相机是在主透镜和感光器之间加入微透镜阵列来获取光线的角度信息和位置信息,然而受感光器分辨率的限制,光场图像往往需要在角度分辨率和空间分辨率之间进行平衡.为进一步解决光场图像分辨率不高的问题,一种方法是提高感光器和微透镜阵列的集成度,但这受到硬件性能的限制.还有一种方式是利用图像超分辨率重建,即利用超分辨率技术将低空间分辨率光场图像转换成高空间分辨率光场图像,或者利用稀疏采样光场生成密集光场[9].近年来,有研究者将传统图像融合方法与光场重聚焦技术相结合生成全聚焦图像,用以提高光场图像的空间分辨率. Yang等人[10]提出了一种基于光场可见性分析的全聚焦图像生成方法,将可见性和最优聚焦深度估计看作多标签优化问题,采用图割法得到最后优化结果.牛娜娜等人[11]提出一种基于微透镜阵列的光场图像全聚焦方法,对原始光场图像进行解码标定构造图像序列并结合空域重聚焦方法,利用清晰度评价算法确定子图像的最佳聚焦点,最后通过图像融合获取全聚焦图像,该方法提高了图像的空间分辨率,改善了图像清晰度.谢颖贤等人[12]通过对光场数据进行变换投影得到重聚焦图像,然后利用小波变换提取高低频子图像,利用区域均衡拉普拉斯算子、像素可见度函数分别构造了融合图像的高、低频小波系数进而重构全聚焦图像,该方法有效避免了传统空域图像融合算法的块效应,改善了人眼视觉效果,提高了图像质量.

综上,研究者在利用图像融合提高图像分辨率、改善图像质量方面取得了大量的研究成果.光场相机具有普通相机所不具备的优点,但光场图像的空间分辨率较低,而图像融合方法可以综合多幅图像细节信息,基于这样的思路,本文利用多聚焦图像融合的方法来解决光场相机成像分辨率低的问题.以Lytro相机光场数据为基础,通过光场重聚焦获取焦点堆栈图像序列,将焦点堆栈图像转换到YCbCr空间,然后对色度通道和亮度通道分别进行处理获取融合亮度和融合色度,最终融合得到清晰的光场全聚焦图像.

全文HTML

-

光场一词最早由A. Gershun提出,是指光辐射在立体空间各个位置各个方向的传播.此后,E. Adelson等人[13]进一步提出了全光函数(plenoptic function),用以描述光线在三维空间中的特性,全光函数的表达式为

式中,L表示空间中的一束光线,(x,y,z)表示空间中一点的坐标,(θ,φ)表示光线的传播方向,λ为光线的波长,t表示时间.可以看出,光线在空间中的传播可以由七维全光函数描述,但这种方式存在着纬度高、数据量大和难以捕获等问题.为此,McMillan等人[14]考虑到光线在空间中传播波长基本保持不变的性质,将某时刻全光函数降为五维函数,即L=L(x,y,z,θ,φ).随后,Levoy等人[15]提出光场渲染理论,将全光函数简化为四维L=L(x,y,u,v),并指出光场可以由两个平行平面参数化表征.

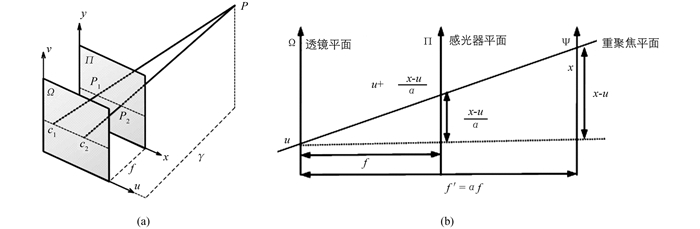

如图 1(a)所示,聚焦平面Π={(x,y)}描述光场的空间分布,相机平面Ω={(u,v)}描述光线的角度方向,f为两个平面的距离.双平面参数化表征光场的意义在于其更易于在传统的成像系统中实现,如用感光器平面记录光线的位置,而用镜头平面(u,v)表示光线的角度.

成像系统通常将采集到的光线数据记录在感光材料上,感光器将不同方向光线的能量进行收集,并以电信号的形式存储在每个像素单元中.像素点的辐射度等于通过主透镜到达该点的所有光线的辐射度的加权积分,即图像是对到达感光器平面的所有光线的积分求和,公式2表示光场能量函数Eαf(x,y).

光场重聚焦是光场成像的重要技术之一.利用光场数字重聚焦技术,可以获得聚焦到不同深度的重聚焦图像,即实现了“先拍照,后聚焦”的效果.如图 1(b)所示,假设

$ \left(u+\frac{x-u}{\alpha}, v+\frac{y-v}{\alpha}, u, v\right)$ 表示空间某光线Lf的投射位置,当光线以某方向沿着直线传播到重聚焦平面Ψ时,记作Lf′.依据相似三角形原理计算可得,空间光线到达感光器平面时的投影位置为(x,y,u,v).其中,f′表示透镜平面Ω和重聚焦平面Ψ之间的距离,并且f′=αf,α为聚焦系数.在自由空间中,光线传播能量不变,则重聚焦图像为Eαf代表聚焦于深度αf处的图像能量信息,通过不断改变聚焦系数α,然后进行积分求解便可得到不同深度的光场重聚焦图像,也即焦点堆栈图像.本文以Lytro相机光场数据为基础,利用时域重聚焦技术首先获取一组光场焦点堆栈图像序列,作为接下来梯度域融合的图像序列.

-

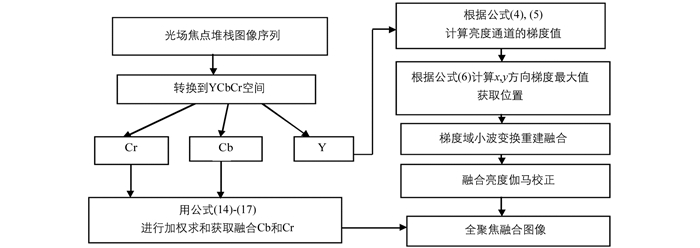

本文提出的梯度域图像融合算法首先将输入的RGB格式图像转换到YCbCr颜色空间,其中亮度Y通道代表图像亮度信息,由于人类视觉系统对亮度Y的敏感度比对色度Cb,Cr的敏感度高,因此在这个通道变化和细节最为明显.在大多数融合算法中,亮度和色度通道的融合采取不同的方式,本文采用基于小波变换的梯度积分法来融合亮度通道,色度通道采用基于像素的加权求和方法融合,本文的图像融合算法的流程图如图 2所示,接下来具体介绍亮度通道和色度通道的融合方法.

-

图像的梯度变化反映了丰富的图像细节信息,在特定的光照条件下,人类的视觉系统对亮度变化更为敏感.例如,拍摄图像中的模糊区域,曝光过度或者曝光不足的区域,其亮度通道的梯度值比那些聚焦度高或者曝光良好的区域梯度值小得多.而在光场焦点堆栈图像中,焦点堆栈同一像素位置梯度值越大,则说明该像素越清晰,即该位置的物体最清晰,对应该张图片中最亮的地方,即亮度值最大的地方.因此对于亮度通道在每个像素位置采用最大化梯度值的方法获取融合亮度,则融合图像将比堆栈中任意一幅图像具有更多的细节区域.

令N个输入的光场焦点堆栈图像亮度通道为I′=(I1,I2…IN),其中N>=2.则堆栈中第n幅图像的亮度通道的梯度定义为

其中Φnx(x,y)和Φny(x,y)分别表示x和y方向上的梯度分量.因此梯度的大小可以表示为

设p(x,y)表示像素位置(x,y)处梯度值最大的图像的编号,用如下公式表示:

则x和y方向融合的亮度梯度分别表示为式(8)、式(9)

其中Φp(x,y)x(x,y)和Φp(x,y)y(x,y)分别表示像素(x,y)处图像p(x,y)的x和y梯度分量,则融合的亮度梯度可以表示为Φ=[Φx,Φy]T.这里,融合亮度梯度具有来自堆栈图像中所有亮度通道的细节信息,然后利用融合梯度重建融合亮度通道,融合梯度Φ和融合亮度通道Ι之间的关系表示为公式(10)

这里

$ \nabla=\left[\frac{\mathrm{d}}{\mathrm{d} x}, \frac{\mathrm{d}}{\mathrm{d} y}\right]^{\mathrm{T}}$ ,求解式(10)中的I就能得到融合亮度.由于融合梯度不是单亮度通道的梯度,而是来自多个亮度通道的梯度的组合,因此融合梯度可能非保守不满足零旋度条件,导致公式(10)无解,为了解决这个问题,我们把它看作一个l2最优化问题进行重建,将公式(10)转化为公式(11)求解为了求解方程(11),本文采用Fattal等人[16]的梯度重建技术,利用梯度模型与Haar小波滤波器之间的关系,计算融合亮度梯度的Haar小波分解系数,然后将这些小波系数合成产生融合亮度通道.在合成过程中,为了克服由于融合梯度不满足零旋度条件而可能产生伪迹的问题,在每个分解层采用基于迭代的泊松求解式,求解过程用递归公式表示为式(12)

其中k是迭代索引,

$ \otimes $ 代表 2D卷积.每一次求解仅需要很小的迭代次数就可以完成,因为有一个好的初始点从而导致快速收敛.该重构算法基于在小波变换的改进版本上,其结果是复杂度O(n),其中n是要重构的信号中的样本数.由于融合梯度是通过合并多个图像梯度值得到的,因此相邻的梯度值之间存在着较大的差异,这可能导致重构图像的像素值有较高的动态范围,某些像素的强度值会超出亮度分量的标准范围,需要对重建的亮度通道的像素值采用线性映射进行调整,但是这样处理的结果往往会导致对比度下降.为了改善对比度,采用类似gamma校正的非线性映射进行校正,如公式(13)所示:

这里

$ \gamma=\frac{\log _{e}\left(R_{C}\right)}{\log _{e}\left(R_{I}\right)}, R_{I}$ 是重构图像的亮度分量的取值范围,RC=H-L,H和L分别是亮度通道中亮度分量的最大值和最小值,以彩色图像的亮度分量为例H=235,L=19,因此RC=216,用公式(13)进行变换后,图像的细节被充分保留,并且合成结果中包含的细节比输入图像的细节更丰富.最后对亮度分量做局部直方图均衡化处理,这样处理后使得整幅图像的亮度分布更均匀. -

色度融合即对输入焦点堆栈图像转换为YCbCr彩色图像的色度通道进行融合,色度融合采用直接处理色度值的方法进行融合,色度融合通过对焦点堆栈图像的色度通道进行加权求和来完成,色度通道中的值范围为16~240,携带有关颜色的信息.当Cb和Cr都等于128时,这些彩色图像在视觉上与灰度图像非常相像,因此携带的颜色信息最少,所以在选择色度通道的权重时这样考虑,每个位置的权重大小取决于该像素处色度值距离128的远近.

假设输入图像的色度通道为

$ C_{b}^{\prime}=\left\{C_{b}^{1}, C_{b}^{2}, \cdots, C_{b}^{N}\right\}$ 和$ C_{r}^{\prime}=\left\{C_{r}^{1}, C_{r}^{2}, \cdots, C_{r}^{N}\right\}$ ,则融合色度通道Cb可以表示为其中

融合色度通道Cr可以表示为

其中

这里|·|返回绝对值.如果位于堆栈中的所有图像的某个像素位置所有色度值都等于128,则相应的权重值就为零.这里要注意,公式(14)-(17)是基于像素的方法,因此与基于梯度的亮度融合相比,计算复杂度低.

2.1. 亮度融合

2.2. 色度融合

-

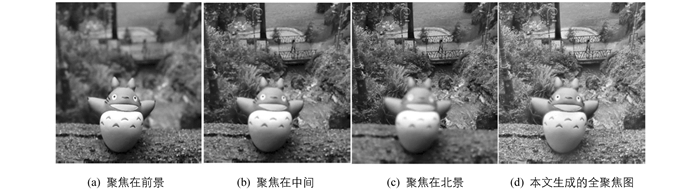

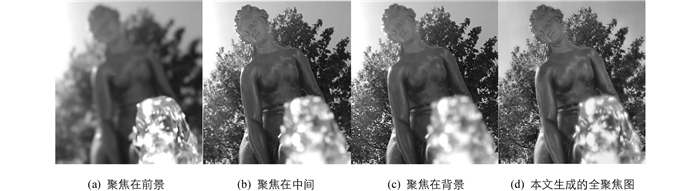

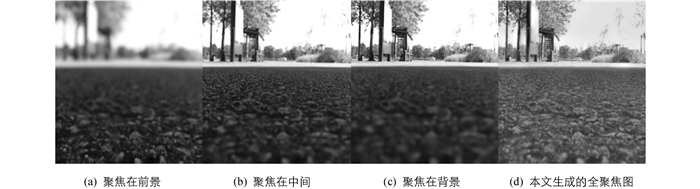

本文实验是在一台硬件配置环境为CPU:Intel coreTMi5-4210U 2.40GHz和RAM:4.0GB,软件编程环境为Matlab R2018a下进行的.实验数据采用Lytro相机拍摄的光场数据[17],数据集中包括30个室内外真实场景,选取4种不同的场景,如图 3-图 6所示.其中(a)、(b)、(c)分别为图像聚焦在前景、聚焦在中间、聚焦在背景. (d)为本文方法生成的光场全聚焦图像,总体来看,本文方法生成的全聚焦图像视觉效果相对较好,图像的细节也较为清晰和丰富.

为进一步定量分析本文所提全聚焦图像生成方法的性能,本文与两种均是基于梯度域的多聚焦图像融合算法[18-19]进行评价和比较.需要说明的是,主流的评价标准均是采用灰度图进行比较和评价的,同时Zhou方法[18]和Tian方法[19]都只能针对两幅聚焦图融合,为客观公正地评价本文所采用方法和Zhou方法、Tian方法生成的全聚焦图像质量,本文采用如图 7所示灰度图像数据集,对3种方法进行定量分析,将相互归一化信息(NMI),QABF和算法时间复杂度用作图像融合质量措施.互信息NMI用来度量融合图像从源图像保留的信息量的大小,互信息值越大说明从源图像中提取的信息越多,融合质量越高.图像间的互信息定义为

其中hR,F(i,j)为理想图像R和融合图像F间的归一化联合灰度直方图分布,hR(i)和hF(j)分别为两幅源图像的归一化边缘直方图分布,L为灰度级.

QABF指标用来度量融合图像与原图像在边缘信息方面的相似性,QABF值越高,表明融合质量越好,计算公式如下:

表 1显示了针对灰度多聚焦数据集的不同融合方法的定量比较结果,最佳结果以粗体显示.从表 1可以看出,本文方法在NMI和QABF方面均优于其它两种基于梯度域的图像融合方法,同时,本文方法执行效率远远高于其它两种方法,这非常有利于处理体积较大的4D光场图像.

-

本文提出了一种基于梯度域的光场全聚焦图像生成方法.通过对光场相机数据进行重聚焦生成光场焦点堆栈图像,然后以光场焦点堆栈图像为基础,将图像按亮度和色度通道分别进行处理和融合,亮度通道的融合采用基于梯度域的图像融合方法,使用基于小波分解的梯度积分算法获得融合亮度,融合色度通道基于像素的色度通道的加权求和方法.在Lytro相机光场数据集上实验表明,研究所提出的基于梯度域光场全聚焦图像生成方法亮度通道融合运行效率高,色度融合方法简单有效,图像细节也较为丰富和清晰,取得了很好的视觉效果.

下载:

下载: