-

开放科学(资源服务)标识码(OSID):

-

近年来,在电子商务和供应链升级的推动下,我国物流基础设施规模持续扩大,各类物流园区数量呈现爆发式增长。根据中华人民共和国应急管理部最新发布的行业安全白皮书数据显示,在物流作业场所发生的安全事故中,因未规范佩戴安全帽防护装备而导致的伤害事件占比较高。为应对这一安全隐患,新修订的《中华人民共和国安全生产法》特别强化了物流企业在个人防护装备管理方面的主体责任。在此背景下,融合计算机视觉、深度学习等新一代信息技术的智能安全监测解决方案,正逐步成为提升物流园区安全管理水平的重要技术手段,并在物流企业中取得显著应用成效[1-2]。

随着新一代信息技术与物流产业的深度融合,智能感知和工业互联技术为物流园区安全管理体系创新注入了新动能。一般情况下安全帽检测[3-5]分为3种方式:①将感应设备嵌入到安全帽内;②根据形状、颜色等多个特征来进行检测;③结合深度学习算法进行智能检测。前2种检测方式操作过程比较复杂,检测速度比较缓慢。以深度学习为基础的神经网络算法,对复杂环境适应性强,且检测效率更高[6],因此基于深度神经网络的识别技术成为安全帽佩戴检测与监管的一种重要方法[7-8]。

基于神经网络算法对安全帽图像进行检测和分割,实际上是采用计算机视觉研究中的语义分割算法对图像进行像素级分类[9-10]。Ren等[11]提出的Faster R-CNN算法相较于单阶段检测算法更加精准,可以解决多尺度、小目标问题,但速度相较于单阶段检测算法更慢[12]。刘雅洁等[13]在主干网络添加坐标注意力机制,提高模型对关键特征的注意力,更聚焦于训练安全帽相关目标特征并提高准确率,但对于密集小目标的检测效果不够理想。Wu等[14]为进一步提高检测精度,将单阶段检测算法和注意力机制进行融合,但该算法同样存在对密集目标检测效果不够理想的问题[15]。田乔鑫等[16]改进了传统的分类算法LeNet-5[17],将支持向量机和神经网络进行结合,该算法因为存在后处理操作,能有效提高目标识别精度,但是在实时性上有待提高。戴天虹等[18]引入EfficientDet算法,将预设边框用于目标检测架构,能进一步提高对小目标的检测精度。

基于工程实施场景下检测任务的高实时性要求,目前以YOLO算法为代表的单阶段目标检测算法应用较为广泛[19-20]。其中针对安全帽佩戴检测任务的代表性研究成果有:徐守坤等[21]基于YOLOv3系列算法进行目标检测和分割,对于安全帽给出了相应的语义描述,但在语义描述的复杂度和多样性上有待提高[22];王玲敏等[23]在YOLOv5算法中引入坐标注意力机制,同时引入加权双向特征金字塔结构,可以有效预测安全帽的位置;吕宗喆等[24]基于YOLOv5算法优化边界框回归损失函数和置信度预测损失函数的计算方式,引入切片辅助微调和切片辅助推理对输入网络的图像进行切片处理,使小目标对象产生更大的像素区域,进而改善网络推理与微调的效果从而提高安全帽佩戴检测的精确性;张锦等[25]针对安全帽尺寸不同的问题,在YOLOv5算法中采用K-Means++算法重新聚类,再引入多光谱通道注意力机制增强信息传播并提高检测效果;杨大为等[26]在YOLOv7算法中引入卷积块注意力机制,同时增加1个小目标层,将浅层网络特征与深层网络特征融合,提高安全帽佩戴检测精度。

针对现有安全帽检测算法参数量过多、复杂度高、对不同场景泛化能力差[27],以及原始DeepLabv3+网络收敛效率低、分割准确率受限的问题,提出一种端到端的基于改进DeepLabv3+的安全帽语义分割算法模型Grid-DeepLabv3+,以期提高复杂场景下物流园区安全帽佩戴的分割精度。

全文HTML

-

相较于原始DeepLabv3+网络,Grid-DeepLabv3+网络主要进行了以下3方面改进:

1) DeepLabv3+主干网络采用的是Xception网络模型,该模型存在网络结构层数较深的问题。采用膨胀残差特征提取网络ResNet-101替换Xception网络,以减小计算量,提高了网络模型的收敛速度,同时也有助于提取图像的高维特征。

2) 为有效关注物流园区图像的显著位置,忽略无关背景信息,将通道注意力机制和空间注意力机制模块放置在编码阶段,有助于提升特征区域表征能力,有效提高图像语义分割的精度。

3) 为有效捕捉物流园区图像小目标特征信息,引入图像特征网格化模块,将低分辨率图像进行平均切分,更好地捕获局部区域的小目标特征信息。

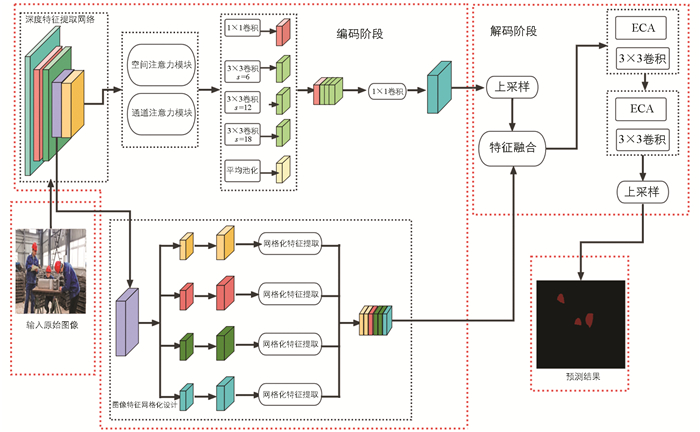

基于Grid-DeepLabv3+网络的语义分割架构如图 1所示。

-

工业物流园区场景图像语义信息比较复杂,分割模型提取图像特征信息的核心部分在编码阶段。本文提出的Grid-DeepLabv3+网络架构编码阶段在3个部分进行了改进,分别为:特征提取网络、卷积注意力机制融合模块、图像特征网格化模块。具体实现方式为:首先将图像数据输入到主干网络ResNet-101中进行特征提取,产生不同尺度的特征图(20×20、40×40、80×80等),对于合并得到的特征图进行不同膨胀率的膨胀卷积学习,获取其特征的同时增加感受野;然后将膨胀卷积学习完成的特征图进行拼接,经过1×1卷积调整通道进行上采样操作以便与接下来处理的特征图融合;最后将特征图进行网格化设计,对不同尺寸的网格化像素上采样后,进行多尺度特征融合,再将经过处理的所有特征合并,通过卷积操作实现像素级分类。具体步骤见算法1。

算法1 编码层网络构建算法 输入:输入特征图Xinput∈RB×C×H×W 输出:输出特征图Youtput∈RB×C×H×W 1. 通过3×3卷积将输入特征图拆分为4部分:[X1,X2,X3,X4]←Conv3×3(Xinput) 2. 合并拆分结果:Xall←[X1,X2,X3,X4] 3. 将Xall拆分为4个子块:{X00,X10,X01,X11}←Split(Xall) 4. 拼接子块:X←Cat({X00,X10,X01,X11}) 5. 对拼接结果进行1×1卷积:X←Conv1×1(X) 6. 网格重组:Xall[index]←Backsplit(X) 7. 合并所有处理后的特征图:X←Cat(Xall) 8. 通过卷积生成最终输出Youtput -

在工业物流园区的图像分割场景中,为了进一步捕捉更广阔的上下文信息,提取丰富语义特征,采用膨胀卷积(Dialted Convolution)进行主干网络特征提取。膨胀卷积是一种通过引入膨胀率来扩大感受野的特殊卷积操作。与标准卷积相比,其核心特点是在卷积核元素之间插入特定间隔,从而在不增加参数量的前提下,显著扩大感受野范围。这种设计具有3大关键优势:①完全避免了传统下采样操作带来的信息损失,完整保留了输入特征图的空间分辨率和细节信息;②通过灵活调节膨胀率,可以动态控制特征提取的感知范围,从局部细节到全局上下文实现多尺度特征捕获;③计算效率更高,不会明显增加模型的计算负担。

标准卷积计算公式为:

式中:P(m,n)为图像上点(m,n)处的像素值;Q(m,n)为卷积核。

膨胀卷积相比标准卷积而言,增加了膨胀率,其计算公式为:

式中:s为膨胀卷积的膨胀率。

膨胀卷积的效果如图 2所示。

-

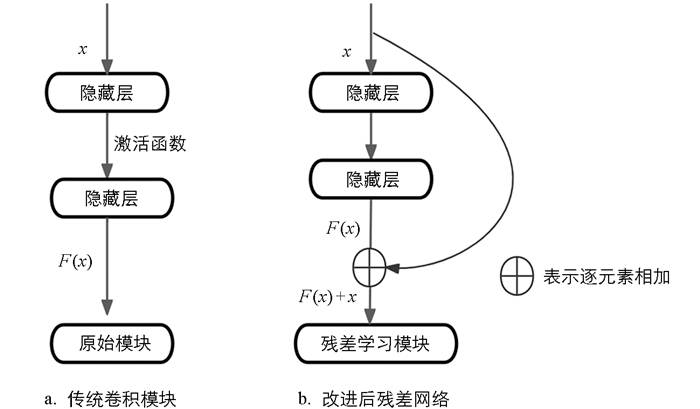

针对训练网络出现过拟合以及准确率不高的现象,He等[28]提出深度卷积残差网络结构,并得到广泛应用[29]。传统的卷积模块如图 3a所示,改进后的残差网络如图 3b所示。若输入的特征为x,则残差函数表示为F(x),那么构建的映射函数H(x)为:

采用ResNet-101残差网络代替网络模型中的骨干提取网络,通过引入残差结构有效缓解深层网络中的梯度消失问题,提升模型表现。残差块是其核心单元,它允许网络学习输入和输出之间的残差,而不是直接从输入到输出的映射。残差块的结构按顺序包括1×1卷积(用于减少通道数)、3×3卷积(用于主要特征提取)和1×1卷积(恢复通道数),并在每个卷积操作后进行批归一化和ReLU激活处理。ResNet-101网络结构包括1个7×7的卷积层(64通道,步幅为2)和1个3×3最大池化层(步幅为2),随后是多个残差块组。具体细节如下:Conv2组有3个残差块(64通道);Conv3组有4个残差块(128通道);Conv4组是关键部分,包含23个残差块(256通道);Conv5组包含3个残差块(512通道)。在最后一个残差块组后,使用全局平均池化层降维,然后通过全连接层输出分类结果。ResNet-101的跳跃连接(Skip Connection)使每个残差块的输入不仅经过卷积处理,还可以直接跳跃到块的输出处,并与卷积结果相加,从而缓解梯度消失问题,增强网络的训练稳定性和深层网络的可训练性。

残差网络可以通过深度的增加来提升特征提取的准确率,其主要特点是容易优化。残差内部通过跳跃连接结构,有效缓解过深的神经网络结构中出现梯度消失的弊端,在一定程度上防止模型过拟合发生。在ResNet-101网络中有多个卷积阶段,针对这些阶段均进行下采样操作从而将图像特征图进行分辨率缩减,通常每个阶段将特征图分辨率缩减为上一阶段的一半。残差膨胀网络在不增加参数量的基础上,能够扩大卷积核的感受野,有助于深层次语义信息的提取,但是对于物流园区场景图像的小目标关注度不够。鉴于以上原因,本文采用2、2、2、3、6的膨胀卷积代替传统卷积进行下采样操作,这样既可以确保特征图的分辨率大小不变,又可以扩大每个阶段的感受野。在F(x)中经过大量实验,选取合适位置引入膨胀卷积对该模块输入的特征图进行特征编码。膨胀卷积在不增加计算复杂度的情况下,能够在保持特征图空间分辨率的同时,捕捉更广泛的上下文信息,它比增加卷积核尺寸或网络深度更加高效。详细算法如算法2所示。

算法2 膨胀残差网络算法 输入:图像I∈RC×H×W 输出:特征图F∈RB×C×H×W 1. 残差块Conv2包含:ResidualblockConv2[i]←[Conv(1×1,64),Conv(3×3,64),Conv(1×1,64)] 2. 跳跃连接:Output[i]←ResidualblockConv2[i]+Input 3. 残差块Conv3:ResidualblockConv3[i]←[Conv(1×1,128),Conv(3×3,128),Conv(1×1,128)] 4. 跳跃连接:Output[i]←ResidualblockConv3[i]+Input 5. 残差块Conv4:ResidualblockConv4[i]←[Conv(1×1,256),Conv(3×3,256),Conv(1×1,256)] 6. 跳跃连接:Output[i]←ResidualblockConv4[i]+Input 7. 残差块Conv5:ResidualblockConv5[i]←[Conv(1×1,512),Conv(3×3,512),Conv(1×1,512)] 8. 跳跃连接:Output[i]←ResidualblockConv5[i]+Input 9. 各卷积层应用空洞卷积,膨胀率为(2,2,2,3,6):DConv←DilatedConv(s=2,2,2,3,6) 10. 将空洞卷积后的多尺度特征拼接:Concatf←Concat(DConv) 11. 通过1×1卷积输出特征图:F←Conv(1×1,Concatf) -

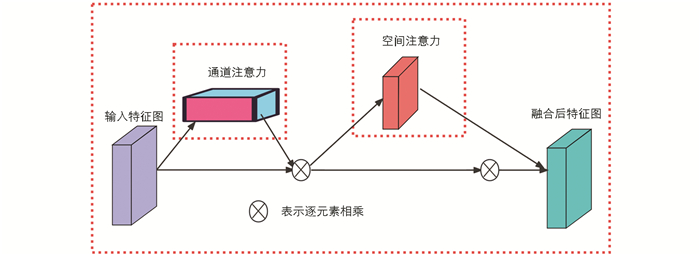

为提升特征提取的有效性,本文创新性地将轻量化的卷积注意力机制融合模块嵌入卷积神经网络架构,在保持模型参数量不变的前提下,通过双注意力机制优化特征学习过程。该模块能够有效抑制背景噪声干扰,动态强化关键特征表达,并自适应地生成通道与空间维度的特征权重分布。具体而言,网络编码器部分采用了如图 4所示的并行注意力结构,其中通道注意力(Channel Attention,CA)模块专注于特征通道间的关系建模,而空间注意力(Spatial Attention,SA)模块则重点捕捉特征图的空间相关性。

针对工业物流园区场景特征图A的处理流程如下:首先输入图像特征图经过通道注意力模块处理,输出维度为一维通道权重向量,记作 Aα∈RC×1×1;随后空间注意力模块对特征图进行空间域分析,生成二维空间权重矩阵Ab∈RC×H×W。2个注意力特征的计算可形式化表示为:

其中:⊗为物流园区场景图像对应元素相乘。

-

通道注意力机制是通过MaxPool和AvePool 2种池化操作实现对图像空间信息的汇总。在物流园区场景图像语义分割任务中,该运算有助于迅速确定图像中的重点部位,有效提升特征区域的表征能力。通道注意力机制先进行MaxPool和AvgPool池化操作,然后将生成的特征图进行全连接操作输出,全连接阶段采取参数共享策略,最终生成的特征图经过Sigmoid激活函数处理,输出通道注意力权重向量,具体可表示为:

式中:A为输入的特征图;S为Sigmoid激活函数;F为全连接操作;ω0、ω1为共享参数;c为特征通道数;Aα(A)为通道注意力模块参数矩阵。

-

空间注意力模块通过AvgPool和MaxPool池化操作,分别提取通道的特征图信息,然后通过5×5的卷积操作进行合并,最后生成空间注意力特征图,具体可表示为:

式中:A为输入的特征图;S为Sigmoid激活函数;f5×5为卷积核大小为5×5的卷积核;Ab(A)为空间注意力模块参数矩阵。

-

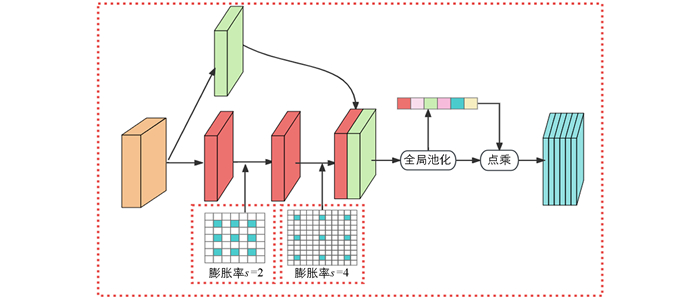

本文提出的Grid-DeepLabv3+网络模型引入图像特征网格化模块。在骨干网络提取图像特征过程中,图像分辨率是一个逐渐下降的过程。当分辨率下降到原始图像的1/32时,将这幅图像进行网格化平均分割,有助于获取局部区域的小目标信息。当然也可以在分辨率下降到原始图像的1/8、1/16等其他比例时进行网格化分割,但过少的分割不足以关注到小目标,过大的分割又会迅速增加模型的参数量,经过反复实验,确定在图像分辨率下降至1/32时进行图像特征网格化分割。

网格化设计特征提取的具体实施方法如算法3所示。首先对第3层特征图进行网格化设计,将4种网格化特征像素通过上采样操作恢复到原来尺寸大小,实现将图像中的小目标进一步放大,有助于提高语义分割的精度,以更好地提取不同目标大小的关键信息,并且增加感受野大小;随后将不同尺度大小特征图上采样进行多尺度特征融合来丰富特征图的内容表示;最后,第4层特征图上采样完成后进行特征融合操作,同时将特征图通道数量通过1×1卷积减少到对应类别数量,实现对图像进行像素级分类。

算法3 网格化设计特征提取算法 输入:第3层特征图Xinput3∈RB×C×H×W;第4层特征图Xinput4∈RB×C×H×W 输出:分类后的图像Y∈RB×C×H×W 1. 将第3层特征图Xinput3∈RB×C×H×W拆分为4个子块:[X3,1,X3,2,X3,3,X3,4]←Xinput3 2. 对子块进行上采样:X3,all←Upsampling([X3,1,X3,2,X3,3,X3,4]) 3. 应用融合函数fusion,遍历X3,all中的每个子块:X3,all[index]←fusion(X) 4. 类似地,对第4层特征图Xinput4进行融合:X4,all[index]←fusion(X) 5. 将融合后的第3层和第4层特征进行拼接:X←Concat(X3,all+X4,all) 6. 通过1×1卷积生成最终输出Y 将变量r作为分割比率,r的取值可以为1、2、3、4等。由图 5可知,分割后小格子内的图像蕴含各个位置的空间特征信息。对于每个小格子图像,通过上采样操作恢复到原来尺寸大小,从而将图像中的小目标进一步放大,这样有助于提高语义分割精度。本文通过引入图像特征网格化模块的设计,能进一步捕获到小目标信息,有效提升图像分割能力。

在图像特征网格化模块中对于原始分辨率1/32的图像,经过上采样还原成分割前的大小,这对有效提取小目标物体提出了挑战。本文在骨干特征提取网络中引入膨胀卷积来分别获取多尺度特征信息,其结构如图 6所示。特征提取网络结构分2步进行特征提取:①采用卷积核大小为1×1的滤波器,通过卷积操作降低特征图的通道数;②将2个膨胀卷积进行串联操作,进一步扩大网络模型的感受野,同时还能保证图像分辨率的大小。最后将2步操作合并成一个新的特征图,进行1次全局池化操作。通过该操作,既可以有效提取中间层信息,又可以对图形中小目标特征进行有效提取,整体上提升了图像语义的分割精度。

2.1. 膨胀卷积

2.2. 膨胀残差网络

2.3. 卷积注意力机制融合模块

2.3.1. 通道注意力模块设计

2.3.2. 空间注意力模块设计

2.4. 图像特征网格化模块

-

为验证语义分割模型Grid-DeepLabv3+适应物流园区安全帽语义分割任务的有效性,采用开源数据集SHWD(Safety Helmet Wearing Detect)进行实验分析。SHWD数据集作为专门用于安全帽佩戴检测的数据集,其设计初衷是涵盖多种复杂场景下的安全帽佩戴情况。该数据集存在多种干扰因素,如光照变化大、人员密集、遮挡情况多、背景复杂多变等。因此从一定程度上讲,SHWD数据集能够反映复杂场景下的安全帽佩戴检测问题。该数据集包含7 581张标注图像,在数据预处理阶段,使用Labelme工具对所有样本进行精细标注,并将数据集划分为6 000张训练样本、581张验证样本和1 000张测试样本,确保模型训练和评估的科学性。

实验硬件和软件环境参数配置如表 1所示。

为提高算法的泛化性能,数据预处理使用MOSAIC数据增强方法。该方法是基于多种图像增强技术设计的一种综合性策略,旨在通过多种手段提升模型的泛化能力。该策略结合了旋转、翻转、颜色调节、高斯噪声添加等操作,从而生成更加多样化和更具挑战性的训练样本。考虑到硬件资源的限制,本文采用640×640的图像分块处理策略。

-

实验选用召回率R、平均交并比mIoU、像素准确率Pa共3个评估指标来衡量改进模型的性能,其中分类任务4个指标及其意义如下:TP表示预测正确的真正例,即模型预测为正例,实际为正例;FP表示预测错误的假正例,即模型预测为正例,实际为反例;FN表示预测错误的假反例,即模型预测为反例,实际为正例;TN表示预测正确的真反例,即模型预测为反例,实际为反例。

召回率R是指预测样本为真值,并且该样本的标签也为真值的个数与所有真值样本个数的比值,其计算公式如下:

平均交并比mIoU是指除了背景之外,计算所有分割标签对象的交并比平均值,其计算公式如下:

式中:s为图像分割中待区分的目标类别总数。

像素准确率Pa是指预测类别正确的像素数占总像素数的比例,其计算公式如下:

-

为验证Grid-DeepLabv3+语义分割网络模型的有效性,分别对3个改进模块进行了消融实验,基准模型选择DeepLabv3+网络。消融实验以mIoU作为评价指标,在SHWD数据集中消融实验的评估结果如表 2所示。由表 2中数据可知,采用DeepLabv3+基础语义分割模型,在SHWD数据集上mIoU为67.28%。本文提出的Grid-DeepLabv3+网络模型在只采用膨胀残差网络的情况下,mIoU提高了0.83个百分点,达到68.11%;当同时采用膨胀残差网络和卷积注意力机制融合模块进行优化时,mIoU提高了1.98个百分点,达到69.26%;当再加入图像特征网格化模块时,mIoU提高了3.93个百分点,达到71.21%。实验结果表明Grid-DeepLabv3+语义分割网络模型在SHWD数据集上的分割效果有明显提升。

-

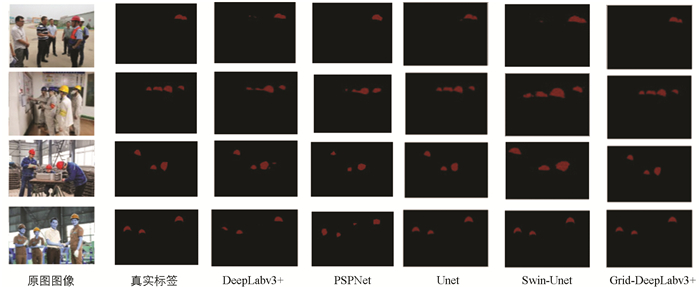

将本文提出的Grid-DeepLabv3+语义分割网络模型与其他经典分割算法(如PSPNet、Unet等)进行对比,相关评估指标有明显的提升。如表 3所示,在SHWD数据集上的对比实验结果表明,Grid-DeepLabv3+以89.23%的Pa和71.21%的mIoU显著优于其他语义分割算法。可视化结果进一步验证了该定量分析结论的一致性,如图 7所示。

3.1. 数据集与实验环境设置

3.2. 定量评估指标

3.3. 模型消融实验结果分析

3.4. 与经典语义分割网络对比

-

物流园区复杂场景下安全帽分割算法的研究,对保障物流园区的安全运行具有重要意义。本文针对目前安全帽分割存在模型识别精度低以及漏检误检等问题,提出了Grid-DeepLabv3+语义分割网络模型。该网络模型对DeepLabv3+网络模型进行了改进,在骨干网络中采用ResNet-101膨胀残差特征提取网络,相较于原来的Xception单元网络,解决了网络结构层数较深的问题,减小了计算量,提高了网络模型收敛速度;在编码阶段引入卷积注意力机制融合模块,有效增强了特征区域表征能力,进一步提升了图像语义分割的精度;在特征提取阶段构建了图像特征网格化模块,将低分辨率图像进行平均切分,更好地获取了物流园区复杂场景中局部区域的小目标特征信息。

本文提出的Grid-DeepLabv3+语义分割网络模型,相较于原始DeepLabv3+模型,在SHWD数据集上的像素准确率Pa提升了2.21个百分点,达到了89.23%。实验结果表明本算法在物流园区安全帽佩戴分割检测中效果良好,为物流园区复杂场景的图像检测分割提供了新的参考。

下载:

下载: