-

开放科学(资源服务)标识码(OSID):

-

近年来,X射线、核磁共振、计算机断层扫描、多普勒彩超等技术不断发展,由此所产生的医学影像也逐渐增加[1]. 不同的医学影像技术涵括了对人类不同身体部位的视觉解读,为了能够做出更合理的诊断,医生大多需要借助以往相关病例的影像资料来判断当前患者所患的病症[2]. 然而,针对如此海量的医学图像,如何快速且高效地检索到相关图像是一项重大挑战.

早期,基于文本的图像检索(Text-Based Image Retrieval,TBIR)是一种主流的检索技术,该技术一般通过图像文本形式的启发式信息(如标签、图像描述符等)进行检索,因此需要工作人员对每一张图像进行手工标注[3]. 然而,针对数以百万计的图像数据,手工标注每一幅图像显然是不现实的. 为了克服这一弊端,基于内容的图像检索(Content-Based Image Retrieval,CBIR)技术迅速兴起. CBIR是一种计算机视觉技术,它提供了一种在大型数据库中搜索相关图像的方法,这种搜索方法通过视觉特征(如颜色、形状和纹理等)来描述图像,而检索精度主要取决于这些选定的特征[4]. 在CBIR中,对于一张给定的待查询图像,系统会从数据库中检索出一些在颜色、形状和纹理等方面与其相似的图像返回给用户. 假设数据库中的图像和待查询图像都是由实值特征表示,搜索相关图像的最简单方法就是根据它们在特征空间中的距离进行排序,并返回距离最近的图像. 然而,对于大规模图像检索而言,CBIR同样面临着存储空间大、检索精度低且速度慢的缺点[5].

为了解决内存成本高、检索速度慢且精度低等一系列问题,基于哈希的图像检索方法被提出并逐渐得到应用. 哈希方法主要是将高维图像特征映射到低维汉明空间并生成紧凑的二进制哈希码,同时还能保持原始图像数据的相似性. 该方法极大地降低了特征维度,避免了维度过高问题,在检索精度和检索速度方面得到了极大改善[6-7]. 哈希方法具体分为两类:数据独立和数据依赖. 其中,在数据独立的哈希算法领域中,最著名的就是局部敏感哈希[8](Locality-Sensitive Hashing,LSH)及其变形算法. 该类算法采用随机映射的方式来获得哈希函数,并且一般需要足够长的哈希码位数才能够达到较高的精度. 相比之下,数据依赖的哈希算法只需要极短的哈希码就可以达到较为理想的精度,该类算法从训练集中学习哈希函数,故又称为学习哈希[9]. 因此,在实际应用中,数据依赖的哈希算法比数据独立的哈希算法更流行.

近年来,受益于深度学习在图像处理方面所表现出的强大性能,人们开始将哈希方法和深度学习相结合,提出了深度哈希算法. 深度哈希算法主要利用卷积神经网络(Convolutional Neural Network,CNN)来提取图像特征,然后利用提取到的特征进行哈希函数学习,这不仅有效避免了语义鸿沟问题,还极大地提高了检索性能[10]. 根据对标签信息的利用,深度哈希算法又分为无监督、半监督和监督3种方式. 一般来说,监督深度哈希算法的精度要高于其他两种方式,代表性的有基于成对标签的深度监督哈希[11]、深度成对监督哈希[12]、深度柯西哈希[13]等,以及基于三元组标签的深度三元标签监督哈希[14]、深度三元组量化[15]、基于注意力的三元哈希[16]等.

2017年,Vaswani等[17]提出了Transformer模型,并在自然语言处理领域取得了巨大成功. 2020年,Carion等[18]提出了DETR模型,并引入Transformer做目标检测任务. 2021年,Dosovitskiy等[19]在Transformer的基础上提出了视觉Transformer模型,并将其应用于计算机视觉领域;Han等[20]在视觉Transformer的基础上提出了TNT模型,进一步提升了模型在数据上的学习能力和泛化性;Wang等[21]提出了PVT模型,并将Pyramid CNN的思路引入Transformer,大幅提高了输出结果的分辨率. 大量实验表明,Transformer在各种计算机视觉任务中(如图像分类[19]、目标识别[22]等)优于许多基于CNN的方法. 近期,在哈希图像检索领域也出现了许多基于Transformer的模型,如VTS[23]、TransHash[24]、HashFormer[25]、ViT2Hash[26]等,这些模型也取得了不错的效果.

基于上述分析,本研究提出面向医学图像检索的视觉Transformer哈希(Vision Transformer Hashing,ViTH)改进算法,同时这也是一种完全不采用CNN作为主架构的深度哈希算法. 本研究使用视觉Transformer作为基础特征提取模块来提取医学图像的视觉特征. 首先在Transformer编码器的前、后端分别加入了幂均值变换(Power-Mean Transformation,PMT)[27]来进一步增强模型的非线性性能,然后在Transformer编码器内部的多头注意力(Multi-Head Attention,MHA)层引入空间金字塔池化(Spatial Pyramid Pooling,SPP)形成多头空间金字塔池化注意力(Multi-Head Spatial Pyramid Pooling Attention,MHSPA)[28]模块,接着在输出幂均值变换之后将提取到的特征分别通过两个多层感知机(Multi-Layer Perceptrons,MLPs),上分支的MLP用来预测图像的类别,下分支的MLP用来学习图像的哈希码,最后通过成对损失、量化损失、平衡损失以及分类损失来优化整个模型.

本研究主要贡献如下:

1) 提出了一种面向医学图像检索的视觉Transformer哈希改进算法.

2) 为了进一步提取具有细微差异的医学图像特征,本研究在多头注意力层中引入空间金字塔池化,形成多头空间金字塔池化注意力模块. 在损失函数中,除了成对损失、量化损失和平衡损失,该算法还设计了分类损失来进一步优化模型所学习的哈希码.

3) 本研究提出的算法不仅仅适用于ChestX-ray14和ISIC 2018,还可以扩展到其他医学图像数据集. 另外,在ChestX-ray14和ISIC 2018医学图像数据集上验证了算法的有效性. 相比目前的算法,本研究取得了较好的检索效果.

全文HTML

-

医学图像具有相似性大、类别多等特性,在大量医学影像中高效准确地检索到所需图像一直是一项挑战. 近年来,很多学者逐渐将哈希算法应用到医学图像检索领域并取得了显著的效果.

Lu等[29]结合模糊逻辑技术和深度神经网络提出深度模糊哈希,利用模糊规则来模拟数据背后的不确定性. Wang等[30]提出基于细粒度相关分析的医学图像检索,有效减少了医学图像中的冗余信息. Xu等[31]针对医学图像提出多流形深度判别跨模态哈希,多模态流形相似性集成了异构数据上的多个子流形以保持实例之间的相关性. Yang等[32]提出一个名为CenterHash的深度贝叶斯哈希学习框架,它可以将多模态数据映射到共享的Hamming空间,并从不平衡的多模态神经图像中学习哈希码,解决了类间差异小和模态间差异大所造成的难题.

-

假设输入图像I∈RH×W×C(其中H,W分别代表图像的高度和宽度,C代表通道数),首先将I分为N个互不重叠的patch,然后将N个patch展平成二维的patches向量XP∈RN×(P2×C)(其中N=HW/P2代表patch的总数),最后将XP通过线性映射层映射到D维空间中,形成序列XPk∈RD,k=1,2,…,N. 位置嵌入被添加到patch编码器之后保留位置信息. 与文献[19]不同的是,本研究不使用0号class token,而是将所形成的N个patch进行编码. 具体过程如下:

式中:E∈RP2×C×D代表线性映射矩阵;Epos∈RN×D代表位置嵌入矩阵.

-

Transformer编码器[17-19]由L个Transformer块组成,每个Transformer块包含层归一化[33](Layer Normalization,LN)、多头注意力机制(Multi-Head Attention,MHA)块和多层感知机(Multi-Layer Perceptron,MLP)块,残差连接[34]分别位于每个块之后. 因此,每个Transformer块的计算公式如下:

式中:MHA,LN和MLP分别代表多头注意力机制块、层归一化以及多层感知机块.

1.1. 医学图像检索

1.2. Patch编码器

1.3. Transformer编码器

-

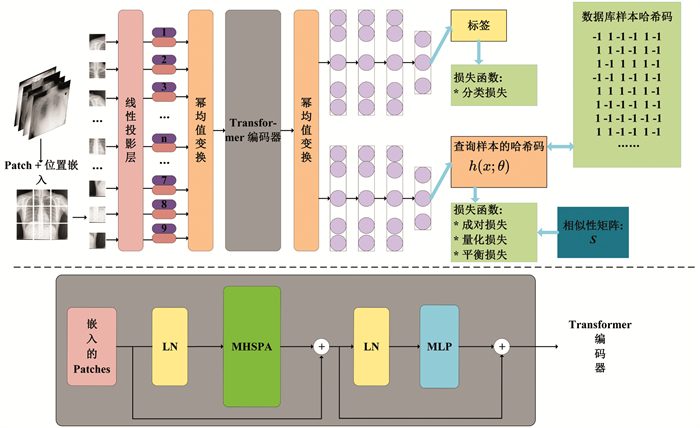

本节详细介绍本研究所提出的算法(ViTH)框架. 首先介绍本研究所使用到的一些符号及含义,然后在此基础上给出ViTH的整体框架(图 1),并详细阐述各模块的具体作用,最后提出模型的损失函数并进行优化.

-

本研究使用v等小写字母表示向量,V等大写字母表示矩阵. V的第i行第j列元素记为Vij;V的第i行记为Vi*;V的第j列记为V*j;V的转置记为VT. ‖·‖代表矩阵的Frobenius范数;⊙代表矩阵间的哈达玛积;tr(·)代表矩阵的迹运算. 此外,符号函数和双曲正切函数的定义如下:

给定医学图像数据库X={xi}i=1n,其中n代表数据库样本的总数. L={li}i=1n∈{0,1}n×c是数据库样本集X的标签信息,其中c代表X的类别数. 样本集X的成对相似性矩阵S一般定义为:如果xi和xj至少共享一个类别,则Sij=1;否则Sij=0. 这显然是有局限性的,因为两张图像共享的标签数越多,则它们之间的相似性越大;反之,如果没有共享的标签,则它们是不相似的. 本研究重新定义成对相似性矩阵[35]

$\boldsymbol{S}=\frac{2\left\|l_i \cap l_j\right\|}{\left\|l_i\right\|+\left\|l_j\right\|-\left\|l_i \cap l_j\right\|} \in[0, 2]^{n \times n}$ . 如果Sij=0,则代表xi与xj不相似;如果Sij=2,则代表xi与xj完全相似;如果Sij介于0到2之间,则代表xi与xj具有一定的相似性. 训练过程中,本研究从数据库样本集X中随机抽取m个样本作为查询集(训练样本)Q={qt}t=1m. 因此,查询集Q和数据库样本集X之间的成对相似性矩阵为S′∈[0, 2]m×n.哈希学习的目的是针对每一个数据库样本xi学习一个哈希函数h(xi)∈{-1,+1}k,以便将各图像映射为紧凑的二进制码B={bi}i=1n∈{-1,+1}n×k,并且所学习的二进制码B可以保持图像在原始空间中的相似性.

-

本研究使用视觉Transformer来提取图像特征. 具体来说,首先将输入图像裁剪成9个大小相同且互不重叠的patch,然后将各patch展平成二维的patches向量. 类似地,本研究使用一个可学习的线性投影层将各向量映射到D(D=2 048)维的空间中,得到序列XPk∈RD,k=1,2,…,9. 位置嵌入则被添加到patch编码器之后,其作用是给各patch添加相对位置,以防丢失位置信息. 与研究[19]不同的是,本研究不使用0号class token,而是将所形成的9个patch进行编码,如公式(1)所示.

此外,本研究在Transformer编码器的前后端分别加入PMT[27]操作来增强模型的非线性. 假设PMT的输入为x、输出为l,PMT则将x变换为[ln(x+β),ln2(x+β)],其中β是一个常数(本研究取β=1). 在前向传播过程中,假设

$\frac{\partial l}{\partial y}$ 是PMT输出的梯度(此处y=[ln(x+β),ln2(x+β)]),由链式法则得:通过前向和反向传播,PMT被集成到整个模型中. 在训练过程中可以学习到更复杂的信息,增强模型的非线性.

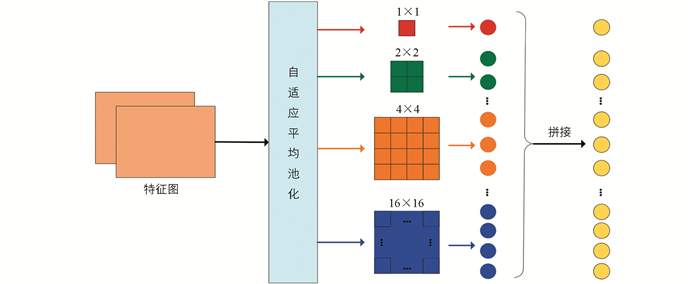

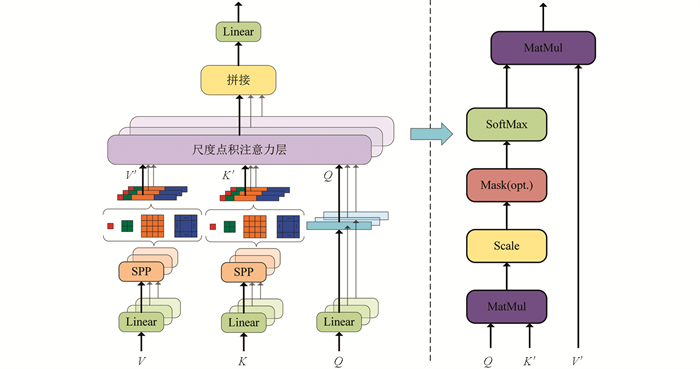

本研究所使用的Transformer编码器的深度是6,并且每个Transformer编码器都是由LN,MHSPA,MLP以及残差连接组成. 图 2为SPP模块,该模块将输入特征图经过自适应平均池化层形成1×1,2×2,4×4和16×16的特征子图,并将形成的特征子图展平拼接. SPP的主要作用是对输入特征图进行不同尺度的特征提取,并生成融合多个区域信息的多尺度特征. 在模型中,本研究将SPP模块嵌入在MHA中形成MHSPA模块,如图 3所示.

注意力机制是将查询Q和一组键值对K,V映射到输出,其中Q,K,V以及输出都是矩阵形式. 输出是通过对V的加权来计算的,分配给每个V的权重则是通过查询Q与相应键K的兼容性函数来计算. 在MHSPA模块中,V和K先通过SPP模块,然后再将查询Q和经过池化的键值对K′和V′通过尺度点积注意力层(图 3),该层计算查询Q和键值对K′和V′之间的注意力分数. 假设尺度点积注意力层的查询Q和键K′的维度为dk,则MHSPA模块的输出为:

式中:K′=SPP(K),V′=SPP(V). Q和K′T之间的点积计算每个查询与所有键之间的相似度,softmax(·)函数对相似度分数进行归一化,以获得每个查询总和为1的注意力权重,比例因子

$\frac{1}{\sqrt{d_k}}$ 用于降低点积幅度的影响. 通过使用尺度点积注意力层,模型可以更好地处理输入中的长距离依赖关系,同时避免了点积的数量级过大导致的数值不稳定问题. 若Transformer编码器的输入为zl,l=1,2,…,L,则输出Zo为:将Transformer编码器的输出再次经过PMT操作,并将输出分别通过两个MLP,其中上分支的MLP用来预测输入图像的类别,下分支的MLP用来生成哈希码.

-

本研究主要考虑了成对损失LP、量化损失LQ以及平衡损失LB[36-38]. 此外,为了能更好地提高精度,还添加了分类损失LC这一约束项.

成对损失LP:训练过程中,本研究通过最小化相似度矩阵S′和查询—数据库样本之间的哈希码内积uivjT的L2损失来保持查询样本和数据库样本之间的相似性. 成对损失具体定义如下:

式中:ui和vj分别代表查询样本和数据库样本的哈希码;ut=h(qt)=sign(Φ(qt;θh));Φ(qt;θh)∈Rk代表哈希编码分支的输出;θh代表哈希编码分支的网络参数.

由于公式(10)的求解是一种离散优化问题,这是极其难以求解的,因此本研究使用双曲正切函数tanh(·)来近似符号函数sign(·),即:

量化损失LQ:由于在成对损失中使用了双曲正切函数tanh(·)来近似符号函数sign(·),因此本研究在网络的实值输出和哈希码之间添加一个正则项,即量化损失LQ:

平衡损失LB:为了使哈希码尽可能地充满整个2k的汉明空间,并保证每一比特的平衡性,本研究提出了平衡损失LB. 该损失函数会确保每一比特上-1和+1出现的概率尽可能地相等,定义如下:

分类损失LC:由于不同图像的标签个数有所差别,有的图像只包含一种疾病,有的却包含多种疾病,本研究在训练过程中针对单标签和多标签图像使用不同的损失函数.

1) 多标签分类损失. 针对多标签图像,分类损失定义如下:

2) 单标签分类损失. 针对单标签图像,分类损失定义如下:

其中,c代表数据库样本集X的类别数;pred(qt;θc)代表图像qt的预测标签;lt代表图像的真实标签;θc代表预测图像类别分支的参数.

因此,总的分类损失函数如下:

-

由2.2.2节得,ViTH模型总的损失函数如下:

其中,α,β和γ都是不敏感的超参数. 本研究使用交替优化算法对式(17)进行求解. 也就是说,在其他参数固定的情况下优化一个参数.

-

当V和θc固定时,使用反向传播算法来更新参数θh. 因此,针对每个查询图像qt,梯度计算如下:

其中zth=Φ(qt;θh). 有了

$\frac{\partial L}{\partial z_{t}^{h}}$ 之后,我们可以根据链式法则计算$\frac{\partial L}{\partial \theta_{h}}$ 另外,由于LB和LC均独立于zth,所以$\frac{\partial L_{B}}{\partial z_{t}^{h}}=0, \frac{\partial L_{C}}{\partial z_{t}^{h}}=0$ . -

当V和θh固定时,使用反向传播算法来更新参数θc. 因此,针对每个查询图像qt,梯度计算如下:

式中:ztc=pred(qt;θc);ε是一个常数. 有了

$\frac{\partial L}{\partial z_{t}^{c}}$ 之后,我们可以根据链式法则计算$\frac{\partial L}{\partial \theta_{c}}$ . 另外,由于LP,LQ和LB均独立于ztc,所以$\frac{\partial L_{P}}{\partial z_{t}^{c}}=0, \frac{\partial L_{Q}}{\partial z_{t}^{c}}=0, \frac{\partial L_{B}}{\partial z_{t}^{c}}=0$ . -

当θh和θc固定时,我们可以重写式(17). 具体如下:

式中:

$\widetilde{U}=\left[\tilde{u}_{1}, \tilde{u}_{2}, \cdots, \tilde{u}_{t}, \cdots, \tilde{u}_{m}\right]^{\mathrm{T}} ; \widetilde{u}_{t}=\tanh \left(\varPhi\left(q_{t} ; \theta_{h}\right)\right), 1=[1, 1, \cdots, 1]^{\mathrm{T}} \in R^{1 \times n} ; \tau$ 是一常数. 另外,由于本研究的查询样本是从数据库样本中随机抽取的,所以$\widetilde{V} \in R^{m \times k}$ 代表查询样本在数据库中所对应的哈希码,$\bar{V} \in R^{n \times k}$ 代表将$\widetilde{V}$ 嵌入在V中的编码.为了简便运算,本研究令

因此,式(20)进一步转化为:

针对式(21),对数据库编码V采用逐比特更新的策略. 也就是说,在更新某一比特哈希码时,固定其他比特保持不变. 因此,等式(21)可以重写为:

因此,式(22)的最优解如下:

-

在模型训练完成之后,对于查询集Q={qt}t=1m之外的样本,本研究通过样本外扩展生成对应样本的哈希码. 具体如下:

-

本研究算法实现步骤如下:

算法1 视觉Transformer哈希算法(ViTH)

输入 数据库样本集X={xi}i=1n,标签矩阵L={li}i=1n∈{0,1}n×c,码长k,批处理大小b,迭代数目iters和epochs.

输出 数据库样本哈希码V,最优神经网络参数θh和θc.

(1) 初始化神经网络参数θh和θc,数据库样本哈希码V;

(2) for iter=1 to iters do

(3) 随机生成查询集Q={qt}t=1m,计算查询—数据库的相似度矩阵S′∈[0, 2]m×n;

(4) for epoch=1 to epochs do

(5) for batch=1 to

$\frac{m}{b}$ do(6) 计算批数据的哈希码,根据式(18)和链式法则更新θh,根据式(19)和链式法则更新θc;

(7) end

(8) end

(9) for bit=1 to k do

(10) 根据式(23)更新V;

(11) end

(12) end

2.1. 符号定义

2.2. 框架

2.2.1. 特征学习模块

2.2.2. 损失函数

2.3. 优化策略

2.3.1. 固定V和θc,更新θh

2.3.2. 固定V和θh,更新θc

2.3.3. 固定θh和θc,更新V

2.4. 样本外扩展

2.5. 算法实现步骤

-

ChestX-ray14:该数据集共包含112 120幅正面的胸部X射线图像,每幅图像的尺寸为1 024×1 024. 除健康人群的图像外,每幅图像都带有一种或多种常见的胸部疾病,共14种. 本研究只关注带有疾病的X射线图像,由于各类疾病的数量是极其不平衡的,因此剔除了数量极少的种类,并对相对较少的疾病图像通过旋转一定角度、水平翻折、垂直翻折等操作进行扩充. 最终,本研究从该数据集获得了47 723张图像,并使其达到相对平衡的状态. 实验过程中,本研究从每种疾病中随机抽取100张图像作为测试样本,其余图像作为数据库样本,训练样本则是每次从数据库样本中随机抽取10 000张.

ISIC 2018:该数据集是一个皮肤镜像数据集,包含黑色素瘤、黑素细胞痣、基底细胞癌等7种疾病,每张图像的尺寸为600×450×3,共计10 208张图像. 由于数据集中各种疾病的数目相差过大,因此本研究剔除了数目极少的2种疾病,并将剩余的5种疾病通过旋转一定角度、水平翻折、垂直翻折等操作进行扩充. 最终,本研究从该数据集获得了16 345张图像,并使其达到相对平衡的状态. 实验过程中,本研究从每种疾病中随机抽取100张图像作为测试样本,其余图像作为数据库样本,训练样本则是每次从数据库样本中随机抽取5 000张.

-

本节主要介绍实验中使用的评估标准.

平均精度(Mean Average Precision,MAP)被广泛用于衡量汉明距离排序的准确性. 为了得到MAP的值,本研究首先引入平均精度(Average Precision,AP). 对于第i个查询图像,AP(i)的定义如下:

式中:M是从数据库中检索到相关图像的总数;N代表数据库中的总样本数;Rn代表前n个返回图像中与查询图像相关的图像总数. 如果返回图像中第n张图像与查询图像相关,则reln=1;否则,reln=0.MAP则是所有AP的平均值,即MAP=mean[AP(i)].

Precision@K代表返回样本中前K个与查询样本相似的平均准确率.

式中:如果返回图像中第i张图像与查询图像相关,则reli=1;否则,reli=0.

-

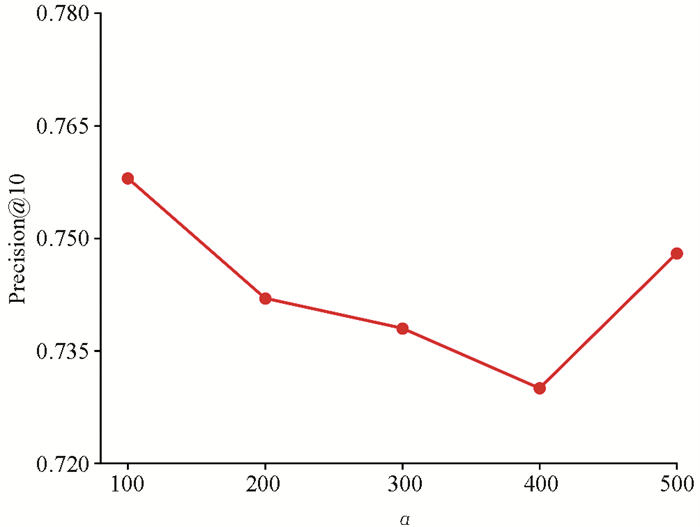

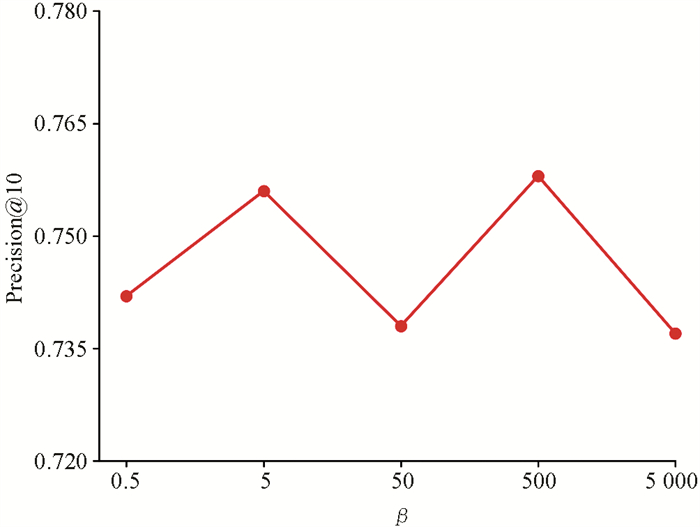

本研究针对ViTH模型的所有实验都是基于Windows系统的服务器完成的(其中CPU配置为:Intel(R) Core(TM) i9-10940X CPU @ 3.30GHz,GPU配置为:NVIDIA GeForce RTX 3090). 经过对超参数的实验分析,本研究设置α=100,β=500,γ=10. 另外batch size为64,迭代次数为50,总epoch为20,初始学习率为0.000 1.

-

本节将所提出的算法(ViTH)与其他几种经典算法进行对比,包括DSH[11],DPSH[12],IDHN[37],DBDH[38],VTS[23],SADH[39]. 简单介绍如下:

DSH[11]:该算法设计了一个CNN架构,将成对的图像(相似/不相似)作为训练输入,并鼓励每个图像的输出接近离散值(例如+1/-1). 另外,设计损失函数并通过对输入图像的监督信息进行编码,同时对实值输出进行正则化以逼近所需的离散值,从而最大限度地提高输出空间的可辨别性.

DPSH[12]:一种深度成对监督哈希,用于对具有成对标签的样本点联合执行特征学习和哈希码学习.

IDHN[37]:一种将语义标签进行归一化并计算其成对量化相似度的哈希方法. 该方法将成对相似度分为硬相似度和软相似度两种情况,并对这两种情况使用不同的损失函数.

DBDH[38]:一种深度平衡离散哈希方法,该方法没有使用传统的连续松弛策略,从而减少了连续松弛带来的量化误差. 在损失函数中,离散值是通过成对损失和平衡控制项来计算的. 学习到的二进制哈希码同时保持相似关系和标签一致性. 在保持成对相似性的同时,该方法保持哈希码的平衡以提高检索性能.

VTS[23]:一种利用预训练的视觉Transformer模型来进行图像检索的方法. 该方法以现有的经典哈希算法为基础,利用ViT模型作为通用的特征提取模块,并将ViT中的MLP替换为各经典算法的哈希模块.

SADH[39]:提出一种具有自监督非对称语义挖掘和边距可扩展约束的新型深度哈希方法. 该方法实现了一个自监督网络,在语义特征字典和语义代码字典中充分保留给定数据集语义的语义信息,高效准确地引导特征学习网络使用非对称学习来保留多标签语义信息策略,并通过进一步利用语义词典以及边距可缩放约束来生成哈希码.

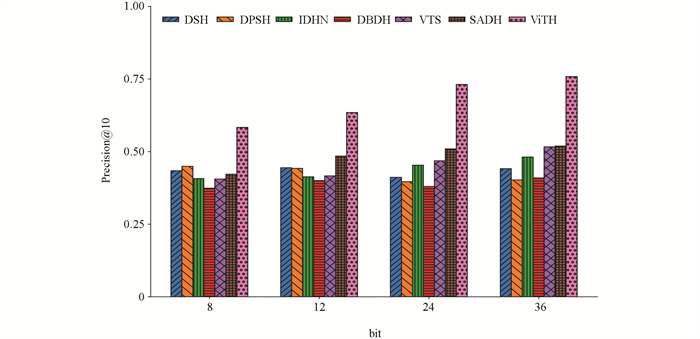

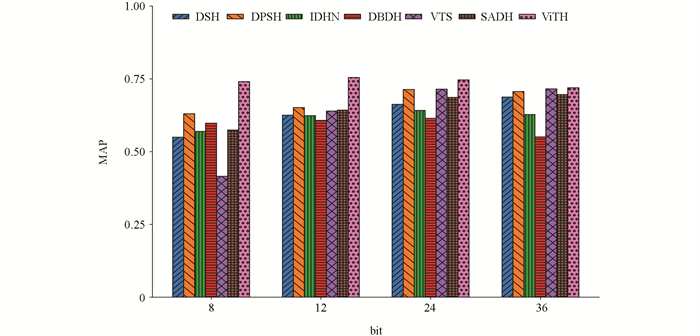

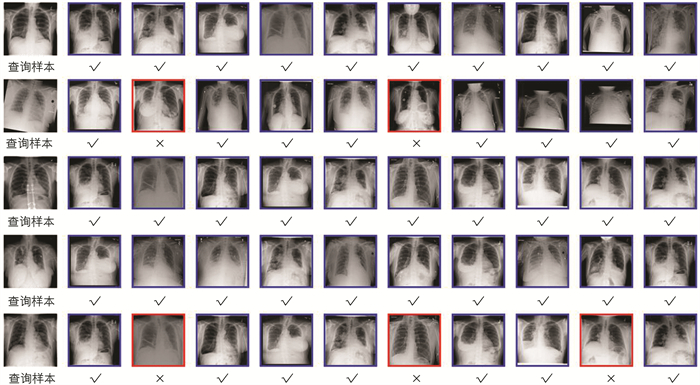

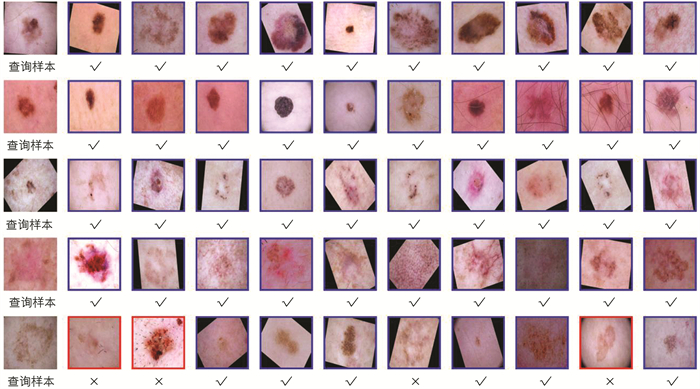

表 1和表 2分别是目前经典的哈希算法在ChestX-ray14和ISIC 2018数据集上的检索结果. 另外为了节省时间,本研究中对比算法(DSH,DPSH,IDHN,DBDH)的实验使用预训练好的AlexNet[40]网络作为特征提取模块. 从表 1(图 4)和表 2(图 5)可以看出,ViTH整体上要优于其他经典算法. 图 6和图 7是ViTH分别在ChestX-ray14和ISIC 2018数据集上随机检索到的前10张图像展示. 其中,蓝色框代表检索到的图像与查询图像至少共享一个类别,红色框代表检索到的图像与查询图像没有共享任一类别.

-

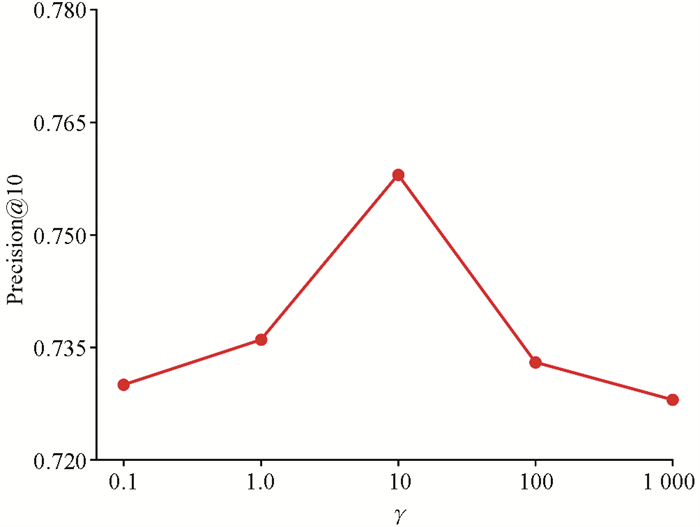

深度学习中,不同数值的超参数对模型的性能影响至关重要[41]. 本节主要针对α,β和γ这3个超参数,使用Precision@10在ChestX-ray14上对36位哈希编码进行超参数分析. 其中,α代表量化损失LQ的权重系数,β代表平衡损失LB的权重系数,γ代表分类损失LC的权重系数. 本研究分别设置α∈{100,200,300,400,500},β∈{0.5,5,50,500,5 000},γ∈{0.1,1,10,100,1 000}进行实验分析. 除超参数的取值外,其他参数的取值仍使用3.3中的实验设置. 图 8-图 10分别是α,β和γ在ChestX-ray14上不同取值下的结果. 由图 8-图 10可知,当α=100,β=500,γ=10时,检索性能最优.

3.1. 实验数据集

3.2. 实验评估指标

3.3. 实验设置

3.4. 实验结果与分析

3.4.1. 对比实验

3.4.2. 超参数分析

-

本研究提出一种面向医学图像检索的视觉Transformer哈希(ViTH)算法. 在Transformer编码器的前后端分别加入PMT模块来进一步增强模型的非线性. 鉴于医学图像之间差异性小且难以分辨的问题,本研究在Transformer编码器内部引入MHSPA模块,该模块不仅可以提取图像的全局上下文特征,而且可以提取多尺度的局部上下文特征,并将不同尺度的特征进行融合. 在损失函数方面,本研究不仅考虑了传统的成对损失、量化损失,还添加了平衡损失和分类损失以对哈希码的映射进一步约束. 本研究在ChestX-ray14和ISIC 2018两个医学图像数据集上与其他多个先进的哈希算法进行实验比较,证明了本研究算法在检索性能方面具有较好的优越性,对关键超参数的变化具有鲁棒性.

另外,本研究算法主要应用在两个领域:①医学图像检索与快速诊断. ViTH算法可以支持医生和研究人员快速获取与特定病例相关的图像. 这有助于提高诊断效率,尤其是在紧急情况下迅速获取相关图像进行诊断. ②医学图像相似性分析. ViTH算法可以量化医学图像之间的相似性,从而帮助医学研究人员进行更准确的图像分析.

最后,本研究虽然在ChestX-ray14和ISIC 2018上取得了良好的实验效果,但仍然存在一些局限性:①现实中各疾病的发病概率是不同的,从而导致医学图像数据集中各类别之间存在不均衡现象,因此模型在检索过程中可能更倾向于占比较大的类别. ②本研究仅关注单模态医学图像,对多模态数据并不适用. 这些局限性也将是本团队未来工作中的重要研究方向.

下载:

下载: